AI同時通訳技術が一般解放された時にできること/できないこと

最近Google翻訳などの、無料ウェブ翻訳ツールの精度が上がったと思いませんか。いまだに長文は苦手のようですが、つい笑ってしまう翻訳文が断然減りましたよね。

【合わせて読む】

●インバウンドマーケティングで外国人観光客に伝える本当の日本とは?

●音声検索とマーケティング|SiriやAlexaは家族の一員になれるか

●MEO対策をすべき業種とSEOとの違い、MEOのメリットデメリットを考える

米IT大手企業も開発を急ぐAI同時通訳技術ですが、それに遅れを取るまいと日本政府も昨年動きました。2018年3月に総務省が同省所管の情報通信研究機構(NICT)が研究を進めていたAI同時通訳の基幹技術を、一般に開放したのです。

2020年にはTOKYO2020 (東京オリンピック&パラリンピック)の開催が控えているので、AI通訳技術を官民で育成し、海外ゲストの対応をよりスムースにすることも狙いのようです。

AIのおかげで失業するであろう職種のベスト10に必ず入る通訳や翻訳の世界。実際にAIに仕事を奪われつつあるのか、現状を確認したいと思います。

目次

一般解放したら、できること

AI同時通訳技術の解放する目的には、その技術を急速に進化させることと、初期投資費用の高さやライセンス契約の手間といったハードルを下げて、民間企業にその先(製品化)を促すことがあります。

加えてその製品から蓄積データを集めて、翻訳精度の向上を図る目的もあります。翻訳精度を高めるには、AIに様々な翻訳データを学習させることが不可欠で、各業界から集めた専門用語の翻訳データなどを学習させることで、幅広い用途での対応が可能になるのです。

日本政府の目論見

GoogleやMicrosoftなどの海外企業に比べ、日本はデータの蓄積で遅れを取っていたのは事実。そこで官民が協力し開発を進められる土壌を確立することで、世界に対抗できるAI同時通訳技術を早急に育てる大命題が総務省に課せられたというわけ。

2020年度は実用化へ

前年のAI同時通訳技術の育成に続き、2019年8月に総務省とNICTは、技術の実用に本腰を入れた施策を発表しました。それは日本語、英語、中国語など15言語に対応する、同時通訳ソフトの開発を2020年度に開始するというものです。ターゲットは大阪で国際博覧会(万博)が開かれる2025年の実用化で、2020年度予算の概算要求に20億円を盛り込むとのことです。

AI同時通訳ソフトで先陣を切れるか

現在流通している音声認識による通訳ソフトは、人が話し終えてから訳が始まるため、会話中に空白時間ができてしまい、それが意思疎通の妨げになっているとされたのです。

翻訳会社の協力を得て各言語で翻訳用の文章を大量に用意し、句点から句点までの各文を意味が通じるまとまりに区切った上で、AIに各文と区切った後とのつながりを学習させます。今回開発するAI同時通訳ソフトは、話している文の途中でも、数秒遅れて訳し始めることができるレベルが目標です。

開発後はNICTが特許技術を広く公開する予定なので、携帯電話会社ではそれをスマートフォン向けのサービスに利用できますし、電機メーカーでは専用端末を開発に着手できるようになります。

AI同時通訳ソフトは海外でも抜きん出た開発例があまりないため、2025年に実用化で日本もこの技術で他国と肩を並べることができる、あるいはリーダーになれると総務省は考えています。

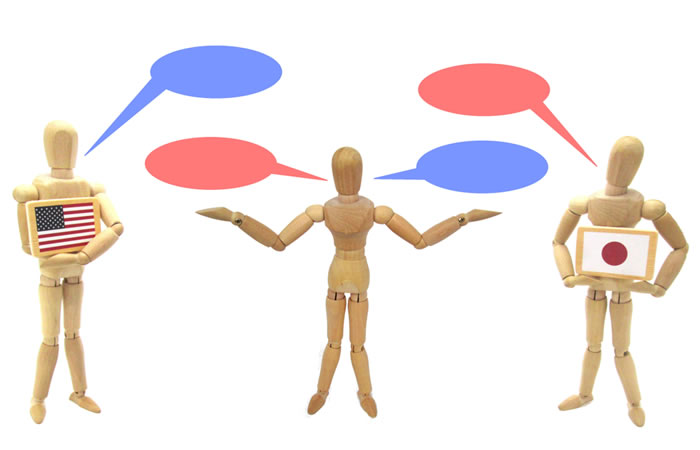

ソフトで同時通訳ができるようになれば、人は重要なところにだけ配置すればよく、商用や日常会話のほか、観光施設やホテルでの訪日客対応にも役立ちますね。また複数の言語で同時に翻訳できるようにすることもめざしているので、国際会議や万博の展示物の紹介にも活用できそうです。

企業側の対応が鍵

AI同時通訳技術の実用化は、企業がどう対応するかが決め手となるでしょう。日本政府と企業のタッグが成立しなければ、AI同時通訳技術で日本が先陣を切るなど、夢で終わります。

現在三菱電機、NEC、富士通、日立など製造業の代表企業、NTT、KDDIなどの通信キャリアなどで、独自に開発を進めているようです。

また中国の騰訊(テンセント)など中国企業も、粛々と開発を進めているようなので、日本が彼らの先を行けるとはまだ確定はできません。

海外では

AI同時通訳技術について、海外IT企業がどのような取り組みをしてるかも確認してみましょう。

Microsoft

Microsoftでは2019年7月の同社パートナー向けイベントのMicrosoft Inspireで、同社CEOによる基調講演で、人間の等身大のホログラフィック映像を投影し、リアルタイムで同時通訳されたことばを、その映像に話させるというデモを行いました。

このホログラムは実在する同社バイスプレジデントを等身大で映し出したもので、彼の話し方やアクセントを保ちながら、日本語に言葉を置き換えて語るという、Microsoftが何年も前から取り組んでいる技術。

このデモを実現するために、MS AzureのSpeech to Text(音声テキスト変換)、Speech Translation(音声翻訳)、Neural Text to Speech(ニューラル版テキスト読み上げ)など、既存の技術が活用され、Azure Speech Servicesのテキスト読み上げ機能では、テキストを人間のような自然な合成音声に変換できるので、ユーザーは、自分だけのカスタム音声を独自に作成できるというものです。Microsoftでは早期の実用化を目指します。

バーチャルリアルティで同時通訳とは、脱帽ですね。

「OK Google、誕生日はドイツ語で何て言う?」と尋ねるとドイツ語の単語を教えてくれる、Googleアシスタントに翻訳機能が搭載されてからしばらく経ちましたが、Googleではさらに会議通訳ができる機能(Interpreter Mode=通訳モード)を導入しようとしています。

その仕組みは次の通りです。たとえば日本人がフランス人とGoogle アシスタントを介して会話する場合、「OK Google、フランス語の通訳者になって」と話しかけて通訳モードを起動すると、双方向で通訳が行われるというもの。日本語で話して数秒するとGoogle アシスタントがその内容をフランス語で出力、相手のフランス人が返事をフランス語で返せば、今度はそれが日本語で返されるのです。この機能は開始にあたって27言語に対応する予定で、今後いくつかの国際イベントで試験運用した上で、一般公開となるようですが、明確なスケジュールはまだ未定。

Google アシスタントの日本語も当初は「?」が多かったですが、学習の成果が出てだいぶまともになりました。通訳機能の本番稼働が楽しみですね。

AIがうまくできないこと

ポケトークWやez:commu(イージーコミュ)といった持ち運び可能な翻訳ツールが市場に出回るようになってきました。外国語が苦手な人が海外に行く際、翻訳ツールを持っていっていざというときに活用することが増えているようですね。

日本語は最後まで聞かないと

翻訳ツールはAIによって進化を遂げていますが、解決すべき課題はまだ多くあるようです。例えば文脈の理解。文法が異なるため、日英・英日翻訳は特に難しいようです。主語がなかったり省略されたりする日本語の文章を、人が行うレベルで英訳することは難しいため、今の技術で対応するには、「あなたは」、「私は」など主語を補う必要が生じます。

また日本語は文末に動詞が来るので、「~します」、「~しません」など、最後で意味が真逆になることがあって、最後まで聞かないと誤訳してしまうのです。

単語量が膨大

フランス語、英語、スペイン語なら、日常で使われる言語の上位3,000語を理解していれば会話が何とか成立するそうですが、日本語では同じ水準になるのに上位1万語が必要になります。

加えて翻訳したい文章が長いほど、翻訳ツールではおかしな翻訳文になってしまいます。ですから翻訳ツールを使うとき、AIが訳しやすいように短い文を入れがちになる日本人が何て多いことか。

ご承知の通りAIには学習能力があります。それはAIのディープラーニング(深層学習)と呼ばれる技術です。今まで人間が学習させていたAIが、インターネットの情報を集めて自学しますので、翻訳に必要な情報も、人間が情報を集める速度の何万倍といった速度で、24時間365日集め続けていけるのです。

AIならではの問題もあります。例えばある文章中に登場する女性であるはずの人物を「彼」とAIが誤訳してしまうことがありますが、その女性の職業が、男性が就くことが多い場合に、サンプルとなった文章から「その職業の場合には、男性形で訳す」という誤った学習をしていることが。誤まった学習結果の洗い出しも、今後の課題になりそうです。

日々進化しながら翻訳の精度をあげていけるため、いずれ何とか人間が受け入れられるレベルの作業を行えるようになるでしょうけれど、比喩や抽象的な表現満載の、文学的な英語の文章を日本語にすることは、AIにはまだま難しいのです。

同時通訳はもっと大変

同時通訳では音声をテキスト化し、その後に翻訳し、翻訳した結果をまた音声にするという流れになるため、翻訳に比べ、音声をテキスト化する分技術が必要です。ディープラーニングによる音声認識が登場したおかげで、テキスト化の精度は上がりましたが、テキストから翻訳することがそもそも難しいのです。

話し言葉は書き言葉に比べて粗いので、主語がないのは当たり前だし、そのほかの言葉が抜け落ちたり、語順が変なこともありますよね。同じことを無意味に繰り返すことや、もっと言えば意味が通じてないことを言うことも。人間同士であれば、表情や言葉のニュアンスからうまく意味を汲み取ることができるので、会話が成立しますがAIに判断はできません。

また、同じコミュニケーションであっても、「テキストだけ」の場合と、「電話での通話」や「対面しての会話」では、同じ言葉なのに、誤解が生じる確率がまったく違ってきますが、同時通訳者(人間)は、そうした言葉で発しないニュアンスも汲み取ることができます。

イタリア人などは概してジェスチャーを多用する人々ですが、AIがジェスチャーをしながらの会話をカバーするのもまだまだ困難です。

AIの機能がもっと向上しないことには、同時通訳の精度を上げるのには限界があるでしょう。

今後

日本語を母国語とする日本人にとっての日本語を話すことは日常的なものですが、外国人にとってこんな難関な言語はありません。日本人全員が英語を理解できるなら問題はないでしょうが、その状態が来ることはまだ遠い。

これから開催される国際イベントを無事乗り切るために、AI同時通訳技術の進化は、日本政府にとって悲願であり、20億円も投資した以上もう引き下がれない状況でしょう。

TOKYO2020までもう1年もありません。まずはデータの蓄積を増やすことが必至、場合によっては海外のデータを活用することも必要になるかもしれません。人の手を借りAIに多くを学習させつつ、AIの機能自体も進化させる取り組みを継続して行う他ありません。

その実用化(ソフト開発)については、企業の尽力にかかってきますので、外国企業とのコンペに打ち勝つべく、日本政府による迅速かつ十分な後方支援が求められます。果たして20億円で事足りるのかに注目ですね。

【合わせて読む】

●インバウンドマーケティングで外国人観光客に伝える本当の日本とは?

●音声検索とマーケティング|SiriやAlexaは家族の一員になれるか

●MEO対策をすべき業種とSEOとの違い、MEOのメリットデメリットを考える